테스트 및 평가

강력한 실증적 평가 만들기

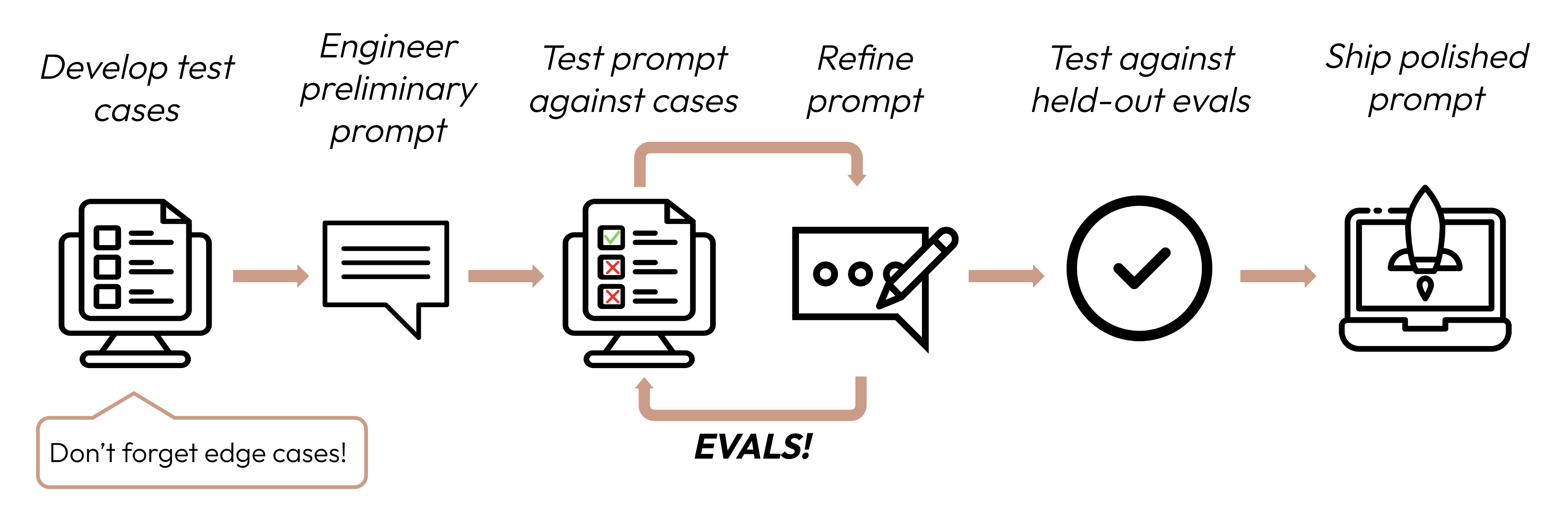

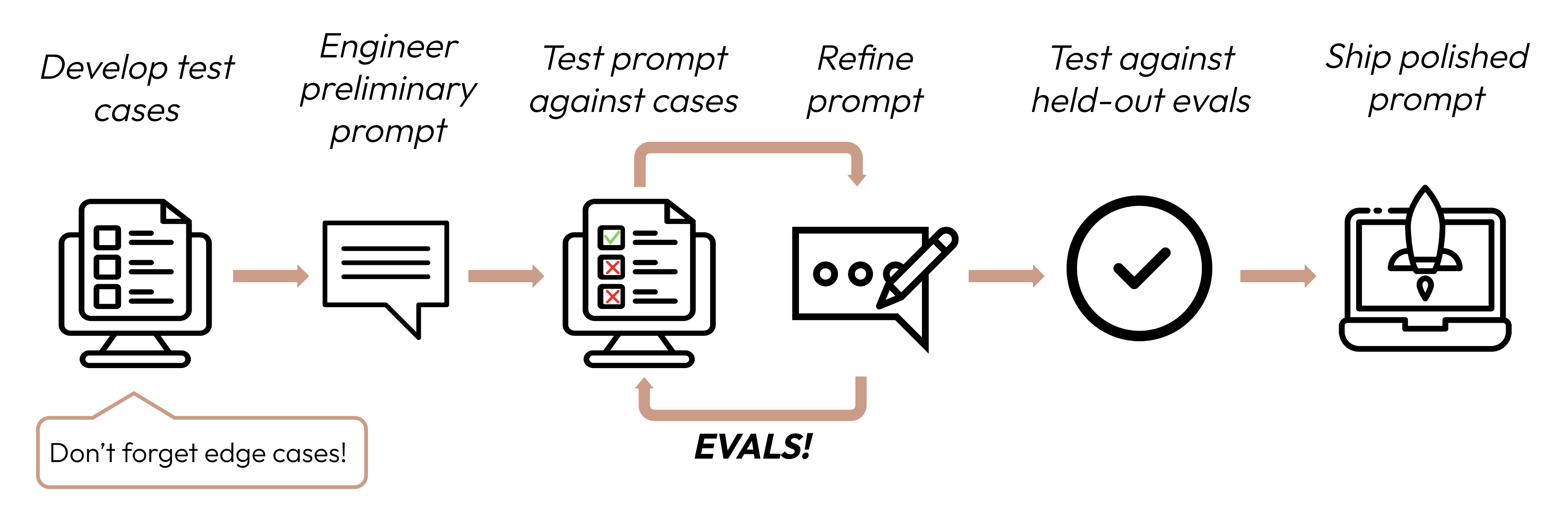

성공 기준을 정의한 후, 다음 단계는 해당 기준에 대한 LLM 성능을 측정하는 평가를 설계하는 것입니다. 이는 프롬프트 엔지니어링 사이클의 중요한 부분입니다.

성공 기준을 정의한 후, 다음 단계는 해당 기준에 대한 LLM 성능을 측정하는 평가를 설계하는 것입니다. 이는 프롬프트 엔지니어링 사이클의 중요한 부분입니다.

평가 및 테스트 케이스 구축

평가 설계 원칙

- 작업별 특성화: 실제 작업 분포를 반영하는 평가를 설계하세요. 엣지 케이스를 고려하는 것을 잊지 마세요!

엣지 케이스 예시

- 관련 없거나 존재하지 않는 입력 데이터

- 지나치게 긴 입력 데이터 또는 사용자 입력

- [채팅 사용 사례] 부적절하거나 유해하거나 관련 없는 사용자 입력

- 인간도 평가 합의에 도달하기 어려운 모호한 테스트 케이스

- 가능한 한 자동화: 자동화된 채점이 가능한 구조의 질문을 만드세요 (예: 객관식, 문자열 매치, 코드 채점, LLM 채점).

- 품질보다 양을 우선시: 약간 낮은 신호의 자동화된 채점을 가진 더 많은 질문이 고품질 인간 수동 채점 평가를 가진 적은 질문보다 낫습니다.

평가 예시

작업 충실도 (감정 분석) - 정확한 매치 평가

작업 충실도 (감정 분석) - 정확한 매치 평가

측정하는 것: 정확한 매치 평가는 모델의 출력이 미리 정의된 정답과 정확히 일치하는지 측정합니다. 감정 분석(긍정, 부정, 중립)과 같이 명확한 범주형 답변이 있는 작업에 완벽한 간단하고 명확한 메트릭입니다.평가 테스트 케이스 예시: 인간이 라벨링한 감정을 가진 1000개의 트윗.

일관성 (FAQ 봇) - 코사인 유사도 평가

일관성 (FAQ 봇) - 코사인 유사도 평가

측정하는 것: 코사인 유사도는 두 벡터(이 경우 SBERT를 사용한 모델 출력의 문장 임베딩) 간의 각도의 코사인을 계산하여 유사성을 측정합니다. 1에 가까운 값은 더 높은 유사성을 나타냅니다. 유사한 질문은 표현이 다르더라도 의미적으로 유사한 답변을 산출해야 하므로 일관성 평가에 이상적입니다.평가 테스트 케이스 예시: 각각 몇 개의 패러프레이즈 버전을 가진 50개 그룹.

관련성 및 일관성 (요약) - ROUGE-L 평가

관련성 및 일관성 (요약) - ROUGE-L 평가

측정하는 것: ROUGE-L (Recall-Oriented Understudy for Gisting Evaluation - Longest Common Subsequence)은 생성된 요약의 품질을 평가합니다. 후보 요약과 참조 요약 간의 가장 긴 공통 부분 수열의 길이를 측정합니다. 높은 ROUGE-L 점수는 생성된 요약이 일관된 순서로 핵심 정보를 포착한다는 것을 나타냅니다.평가 테스트 케이스 예시: 참조 요약이 있는 200개의 기사.

톤과 스타일 (고객 서비스) - LLM 기반 리커트 척도

톤과 스타일 (고객 서비스) - LLM 기반 리커트 척도

측정하는 것: LLM 기반 리커트 척도는 LLM을 사용하여 주관적 태도나 인식을 판단하는 심리측정 척도입니다. 여기서는 1부터 5까지의 척도로 응답의 톤을 평가하는 데 사용됩니다. 전통적인 메트릭으로는 정량화하기 어려운 공감, 전문성, 인내심과 같은 미묘한 측면을 평가하는 데 이상적입니다.평가 테스트 케이스 예시: 목표 톤(공감적, 전문적, 간결한)을 가진 100개의 고객 문의.

개인정보 보호 (의료 챗봇) - LLM 기반 이진 분류

개인정보 보호 (의료 챗봇) - LLM 기반 이진 분류

측정하는 것: 이진 분류는 입력이 두 클래스 중 하나에 속하는지 결정합니다. 여기서는 응답에 PHI가 포함되어 있는지 여부를 분류하는 데 사용됩니다. 이 방법은 맥락을 이해하고 규칙 기반 시스템이 놓칠 수 있는 미묘하거나 암시적인 형태의 PHI를 식별할 수 있습니다.평가 테스트 케이스 예시: 일부는 PHI를 포함한 500개의 시뮬레이션된 환자 질의.

맥락 활용 (대화 어시스턴트) - LLM 기반 서수 척도

맥락 활용 (대화 어시스턴트) - LLM 기반 서수 척도

측정하는 것: 리커트 척도와 유사하게, 서수 척도는 고정된 순서 척도(1-5)로 측정합니다. 모델이 대화 기록을 참조하고 구축하는 정도를 포착할 수 있어 일관되고 개인화된 상호작용의 핵심인 맥락 활용을 평가하는 데 완벽합니다.평가 테스트 케이스 예시: 맥락 의존적 질문이 있는 100개의 다중 턴 대화.

수백 개의 테스트 케이스를 손으로 작성하는 것은 어려울 수 있습니다! 기본 예시 테스트 케이스 세트에서 더 많은 케이스를 생성하도록 Claude에게 도움을 요청하세요.

성공 기준을 평가하는 데 어떤 평가 방법이 유용할지 모르겠다면, Claude와 브레인스토밍할 수도 있습니다!

평가 채점

평가를 채점하는 데 사용할 방법을 결정할 때, 가장 빠르고 신뢰할 수 있으며 확장 가능한 방법을 선택하세요:-

코드 기반 채점: 가장 빠르고 신뢰할 수 있으며, 매우 확장 가능하지만, 규칙 기반 경직성이 덜 필요한 더 복잡한 판단에 대한 뉘앙스가 부족합니다.

- 정확한 매치:

output == golden_answer - 문자열 매치:

key_phrase in output

- 정확한 매치:

- 인간 채점: 가장 유연하고 고품질이지만 느리고 비쌉니다. 가능하면 피하세요.

- LLM 기반 채점: 빠르고 유연하며, 확장 가능하고 복잡한 판단에 적합합니다. 먼저 신뢰성을 테스트한 다음 확장하세요.

LLM 기반 채점을 위한 팁

- 상세하고 명확한 루브릭 작성: “답변은 항상 첫 번째 문장에서 ‘Acme Inc.‘를 언급해야 합니다. 그렇지 않으면 답변은 자동으로 ‘부정확’으로 채점됩니다.”

주어진 사용 사례나 해당 사용 사례의 특정 성공 기준도 전체적인 평가를 위해 여러 루브릭이 필요할 수 있습니다.

- 실증적이거나 구체적: 예를 들어, LLM에게 ‘정확’ 또는 ‘부정확’만 출력하거나 1-5 척도로 판단하도록 지시하세요. 순전히 정성적인 평가는 빠르고 대규모로 평가하기 어렵습니다.

- 추론 장려: LLM에게 평가 점수를 결정하기 전에 먼저 생각하도록 요청한 다음 추론을 버리세요. 이는 특히 복잡한 판단이 필요한 작업에서 평가 성능을 향상시킵니다.

예시: LLM 기반 채점

예시: LLM 기반 채점