测试与评估

使用评估工具

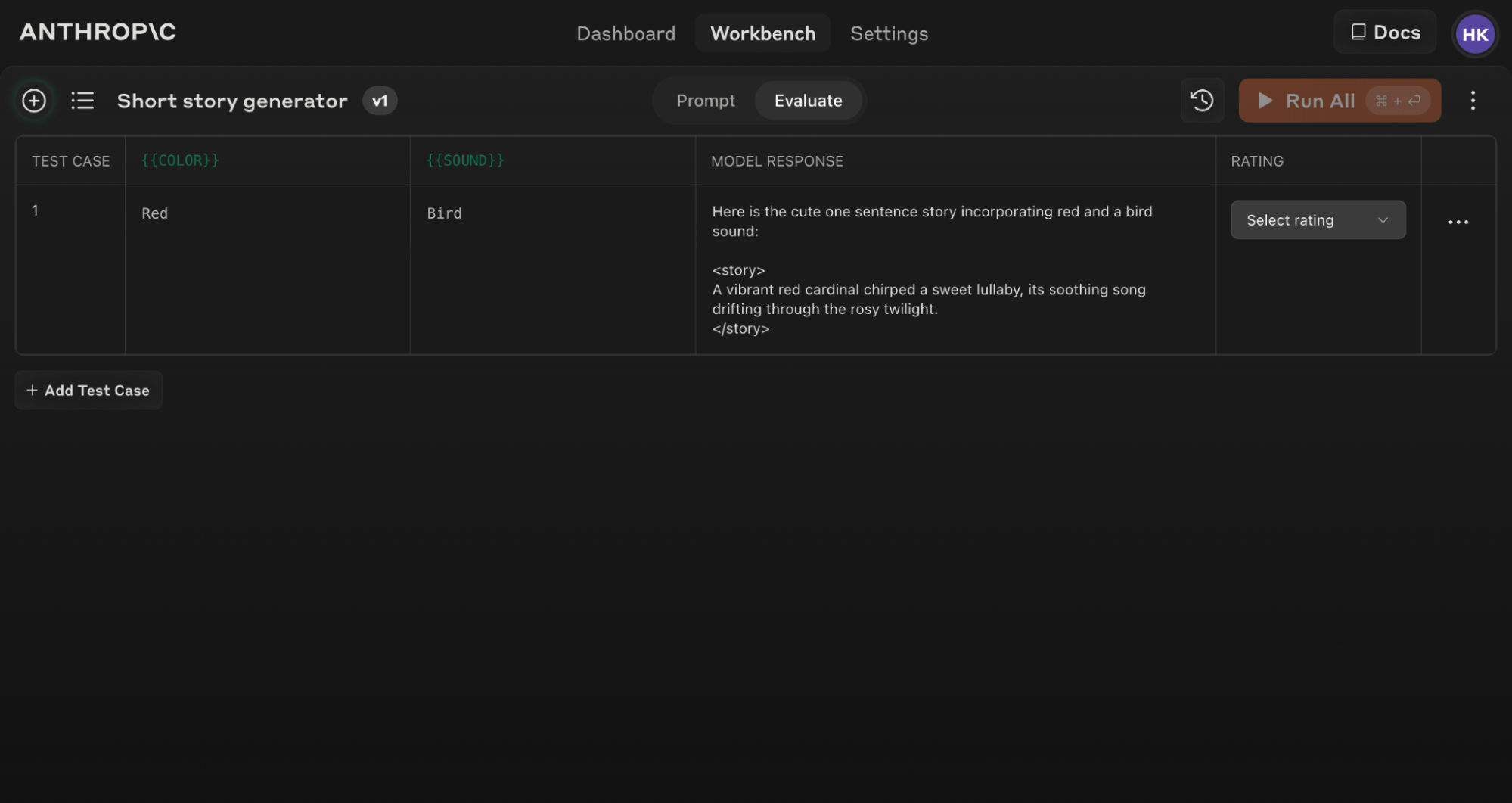

Anthropic Console 提供了一个评估工具,允许您在各种场景下测试您的提示。

访问评估功能

要开始使用评估工具:- 打开 Anthropic Console 并导航到提示编辑器。

- 编写完提示后,在屏幕顶部寻找”Evaluate”选项卡。

确保您的提示包含至少 1-2 个使用双大括号语法的动态变量:{{variable}}。这是创建评估测试集所必需的。

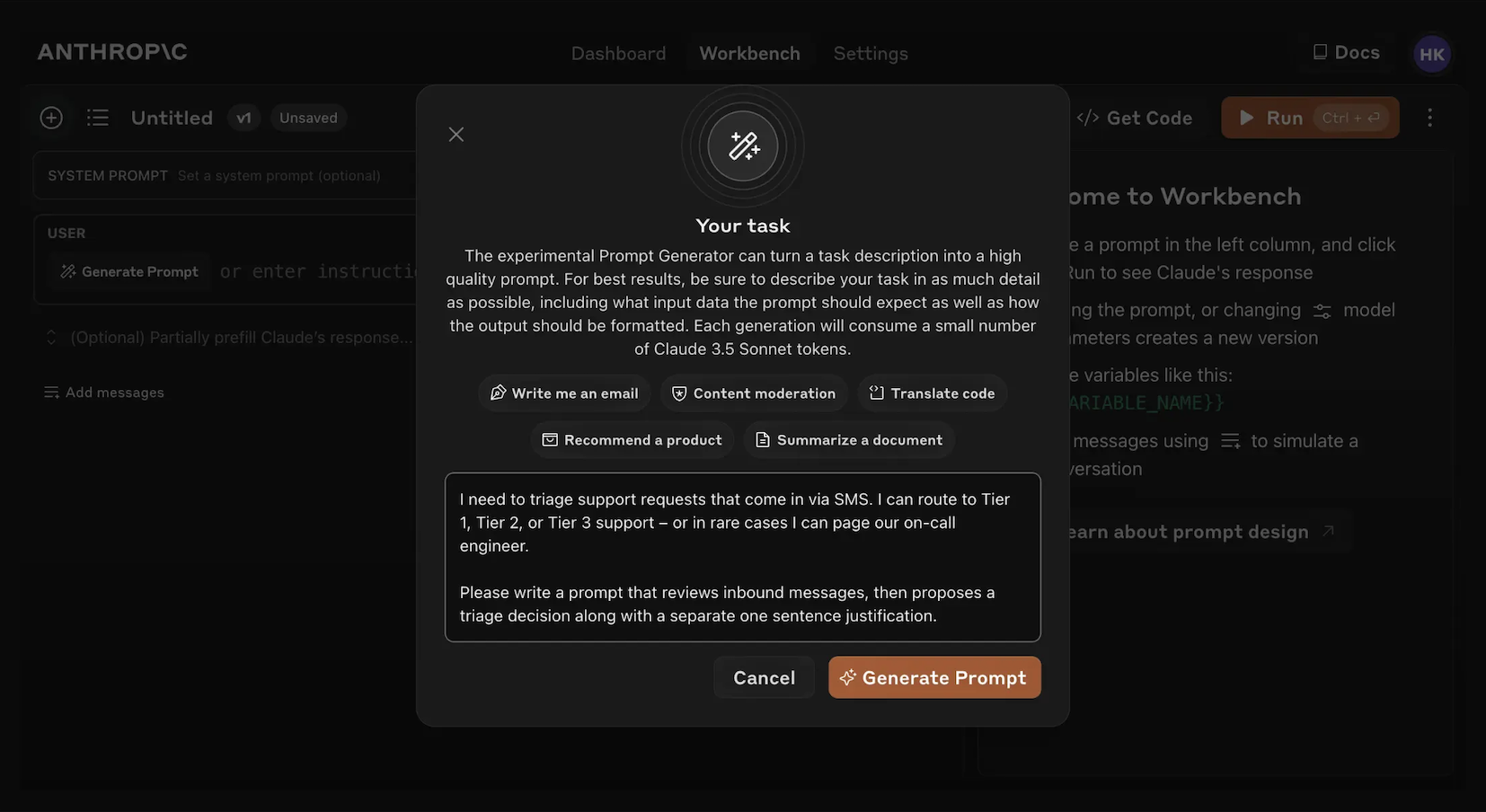

生成提示

Console 提供了一个由 Claude Opus 4.1 驱动的内置提示生成器:1

点击'Generate Prompt'

点击”Generate Prompt”辅助工具将打开一个模态框,允许您输入任务信息。

2

描述您的任务

描述您想要的任务(例如,“分类入站客户支持请求”),可以提供尽可能多或少的详细信息。您包含的上下文越多,Claude 就越能为您的特定需求定制生成的提示。

3

生成您的提示

点击底部的橙色”Generate Prompt”按钮将让 Claude 为您生成高质量的提示。然后您可以使用 Console 中的评估屏幕进一步改进这些提示。

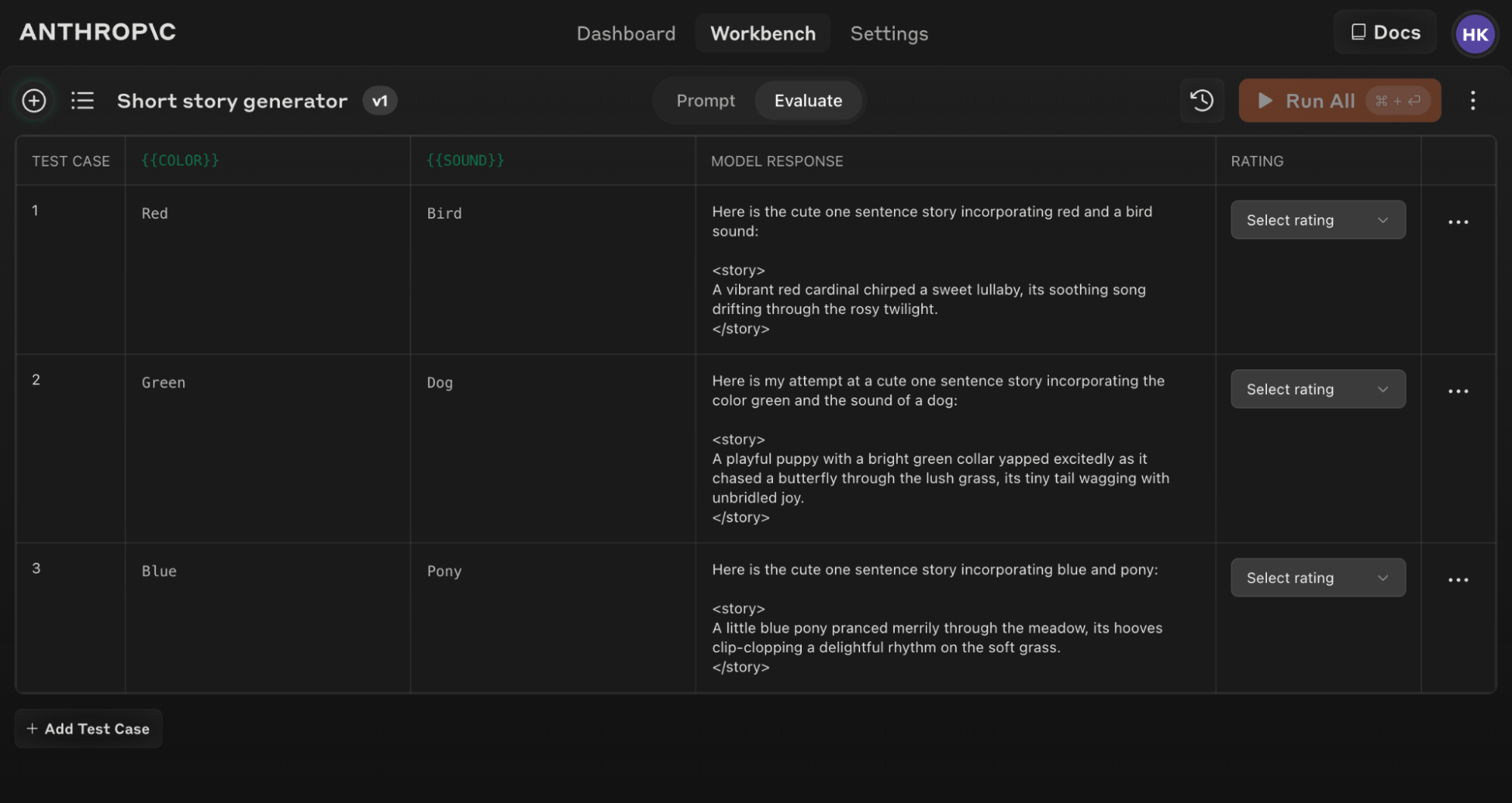

创建测试用例

当您访问评估屏幕时,您有几个选项来创建测试用例:- 点击左下角的”+ Add Row”按钮手动添加用例。

- 使用”Generate Test Case”功能让 Claude 自动为您生成测试用例。

- 从 CSV 文件导入测试用例。

1

点击'Generate Test Case'

Claude 将为您生成测试用例,每次点击按钮时生成一行。

2

编辑生成逻辑(可选)

您还可以通过点击”Generate Test Case”按钮右侧的箭头下拉菜单,然后点击弹出的变量窗口顶部的”Show generation logic”来编辑测试用例生成逻辑。您可能需要点击此窗口右上角的”Generate”来填充初始生成逻辑。编辑此项允许您自定义和微调 Claude 生成的测试用例,以获得更高的精度和特异性。

如果您更新了原始提示文本,您可以针对新提示重新运行整个评估套件,以查看更改如何影响所有测试用例的性能。

有效评估的技巧

用于评估的提示结构

用于评估的提示结构

要充分利用评估工具,请使用清晰的输入和输出格式构建您的提示。例如:这种结构使得变化输入({{COLOR}} 和 {{SOUND}})和一致地评估输出变得容易。

使用 Console 中的”Generate a prompt”辅助工具快速创建具有适当变量语法的提示以进行评估。

理解和比较结果

评估工具提供了几个功能来帮助您完善提示:- 并排比较:比较两个或更多提示的输出,快速查看您的更改的影响。

- 质量评分:在 5 分制上对响应质量进行评分,以跟踪每个提示的响应质量改进。

- 提示版本控制:创建提示的新版本并重新运行测试套件,以快速迭代和改进结果。