Testen & bewerten

Starke empirische Evaluierungen erstellen

Entwickeln Sie Testfälle zur Messung der LLM-Leistung gegen Ihre Erfolgskriterien.

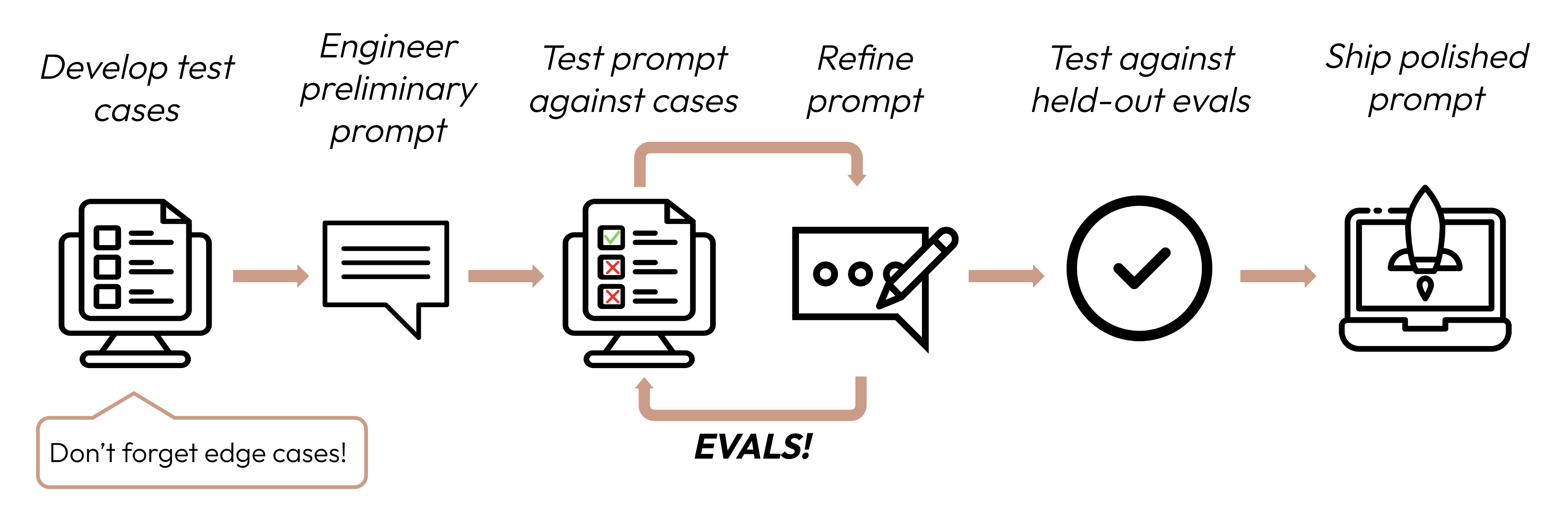

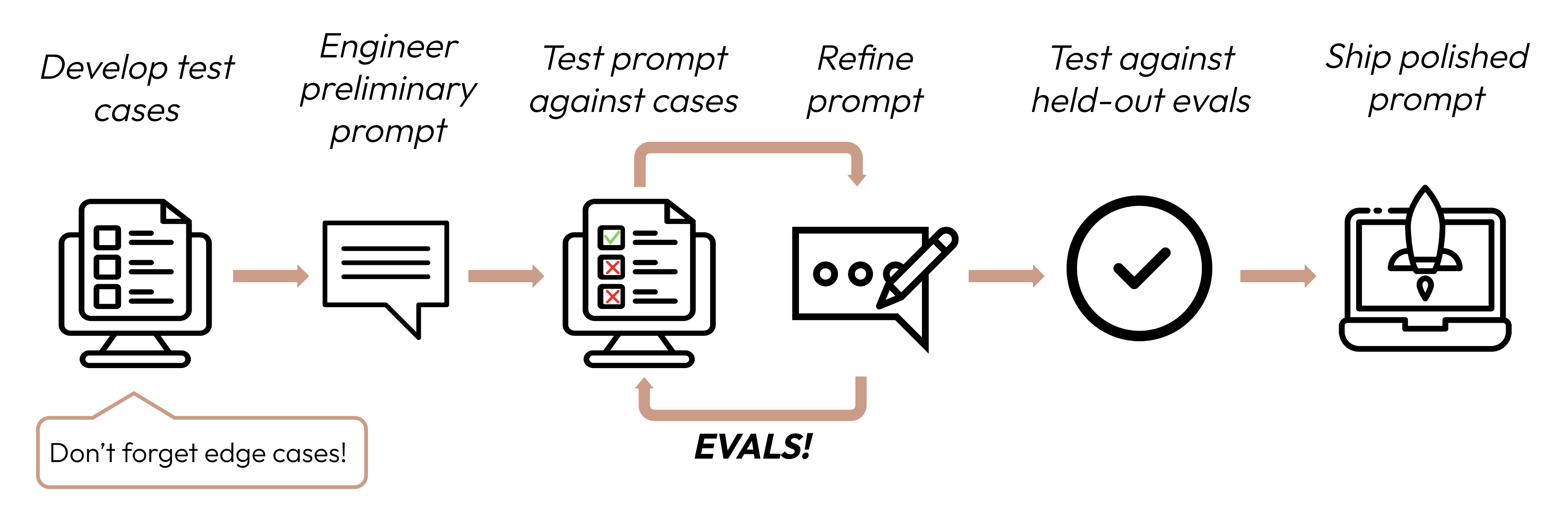

Nach der Definition Ihrer Erfolgskriterien ist der nächste Schritt die Gestaltung von Evaluierungen zur Messung der LLM-Leistung gegen diese Kriterien. Dies ist ein wichtiger Teil des Prompt-Engineering-Zyklus.

Evals und Testfälle erstellen

Eval-Design-Prinzipien

- Aufgabenspezifisch sein: Entwerfen Sie Evals, die Ihre reale Aufgabenverteilung widerspiegeln. Vergessen Sie nicht, Grenzfälle zu berücksichtigen!

Beispiel-Grenzfälle

- Irrelevante oder nicht existierende Eingabedaten

- Übermäßig lange Eingabedaten oder Benutzereingaben

- [Chat-Anwendungsfälle] Schlechte, schädliche oder irrelevante Benutzereingaben

- Mehrdeutige Testfälle, bei denen selbst Menschen schwer einen Bewertungskonsens erreichen würden

- Wenn möglich automatisieren: Strukturieren Sie Fragen so, dass automatisierte Bewertung möglich ist (z.B. Multiple-Choice, String-Match, Code-bewertet, LLM-bewertet).

- Volumen über Qualität priorisieren: Mehr Fragen mit etwas niedrigerem Signal bei automatisierter Bewertung ist besser als weniger Fragen mit hochwertigen manuell bewerteten Evals.

Beispiel-Evals

Aufgabentreue (Sentimentanalyse) - Exakte Übereinstimmungsevaluierung

Aufgabentreue (Sentimentanalyse) - Exakte Übereinstimmungsevaluierung

Was es misst: Exakte Übereinstimmungs-Evals messen, ob die Ausgabe des Modells genau mit einer vordefinierten korrekten Antwort übereinstimmt. Es ist eine einfache, eindeutige Metrik, die perfekt für Aufgaben mit klaren, kategorischen Antworten wie Sentimentanalyse (positiv, negativ, neutral) ist.Beispiel-Eval-Testfälle: 1000 Tweets mit menschlich markierten Sentiments.

Konsistenz (FAQ-Bot) - Kosinus-Ähnlichkeitsevaluierung

Konsistenz (FAQ-Bot) - Kosinus-Ähnlichkeitsevaluierung

Was es misst: Kosinus-Ähnlichkeit misst die Ähnlichkeit zwischen zwei Vektoren (in diesem Fall Satz-Embeddings der Modellausgabe mit SBERT) durch Berechnung des Kosinus des Winkels zwischen ihnen. Werte näher zu 1 zeigen höhere Ähnlichkeit an. Es ist ideal zur Bewertung von Konsistenz, da ähnliche Fragen semantisch ähnliche Antworten liefern sollten, auch wenn die Formulierung variiert.Beispiel-Eval-Testfälle: 50 Gruppen mit jeweils einigen paraphrasierten Versionen.

Relevanz und Kohärenz (Zusammenfassung) - ROUGE-L-Evaluierung

Relevanz und Kohärenz (Zusammenfassung) - ROUGE-L-Evaluierung

Was es misst: ROUGE-L (Recall-Oriented Understudy for Gisting Evaluation - Longest Common Subsequence) bewertet die Qualität generierter Zusammenfassungen. Es misst die Länge der längsten gemeinsamen Teilsequenz zwischen der Kandidaten- und Referenzzusammenfassung. Hohe ROUGE-L-Werte zeigen an, dass die generierte Zusammenfassung wichtige Informationen in kohärenter Reihenfolge erfasst.Beispiel-Eval-Testfälle: 200 Artikel mit Referenzzusammenfassungen.

Ton und Stil (Kundenservice) - LLM-basierte Likert-Skala

Ton und Stil (Kundenservice) - LLM-basierte Likert-Skala

Was es misst: Die LLM-basierte Likert-Skala ist eine psychometrische Skala, die ein LLM verwendet, um subjektive Einstellungen oder Wahrnehmungen zu beurteilen. Hier wird sie verwendet, um den Ton von Antworten auf einer Skala von 1 bis 5 zu bewerten. Sie ist ideal zur Bewertung nuancierter Aspekte wie Empathie, Professionalität oder Geduld, die mit traditionellen Metriken schwer zu quantifizieren sind.Beispiel-Eval-Testfälle: 100 Kundenanfragen mit Zielton (empathisch, professionell, prägnant).

Datenschutzbewahrung (medizinischer Chatbot) - LLM-basierte binäre Klassifikation

Datenschutzbewahrung (medizinischer Chatbot) - LLM-basierte binäre Klassifikation

Was es misst: Binäre Klassifikation bestimmt, ob eine Eingabe zu einer von zwei Klassen gehört. Hier wird sie verwendet, um zu klassifizieren, ob eine Antwort PHI enthält oder nicht. Diese Methode kann Kontext verstehen und subtile oder implizite Formen von PHI identifizieren, die regelbasierte Systeme möglicherweise übersehen.Beispiel-Eval-Testfälle: 500 simulierte Patientenanfragen, einige mit PHI.

Kontextnutzung (Gesprächsassistent) - LLM-basierte Ordinalskala

Kontextnutzung (Gesprächsassistent) - LLM-basierte Ordinalskala

Was es misst: Ähnlich der Likert-Skala misst die Ordinalskala auf einer festen, geordneten Skala (1-5). Sie ist perfekt zur Bewertung der Kontextnutzung, da sie den Grad erfassen kann, in dem das Modell auf die Gesprächshistorie verweist und darauf aufbaut, was für kohärente, personalisierte Interaktionen entscheidend ist.Beispiel-Eval-Testfälle: 100 mehrteilige Gespräche mit kontextabhängigen Fragen.

Hunderte von Testfällen von Hand zu schreiben kann schwierig sein! Lassen Sie Claude Ihnen helfen, mehr aus einem Basissatz von Beispiel-Testfällen zu generieren.

Wenn Sie nicht wissen, welche Eval-Methoden nützlich sein könnten, um Ihre Erfolgskriterien zu bewerten, können Sie auch mit Claude brainstormen!

Evals bewerten

Bei der Entscheidung, welche Methode zur Bewertung von Evals verwendet werden soll, wählen Sie die schnellste, zuverlässigste, skalierbarste Methode:-

Code-basierte Bewertung: Am schnellsten und zuverlässigsten, extrem skalierbar, aber fehlt auch Nuancen für komplexere Beurteilungen, die weniger regelbasierte Starrheit erfordern.

- Exakte Übereinstimmung:

output == golden_answer - String-Übereinstimmung:

key_phrase in output

- Exakte Übereinstimmung:

- Menschliche Bewertung: Am flexibelsten und hochwertigsten, aber langsam und teuer. Wenn möglich vermeiden.

- LLM-basierte Bewertung: Schnell und flexibel, skalierbar und geeignet für komplexe Beurteilungen. Zuerst auf Zuverlässigkeit testen, dann skalieren.

Tipps für LLM-basierte Bewertung

- Detaillierte, klare Rubriken haben: “Die Antwort sollte immer ‘Acme Inc.’ im ersten Satz erwähnen. Wenn nicht, wird die Antwort automatisch als ‘falsch’ bewertet.”

Ein gegebener Anwendungsfall oder sogar ein spezifisches Erfolgskriterium für diesen Anwendungsfall könnte mehrere Rubriken für eine ganzheitliche Bewertung erfordern.

- Empirisch oder spezifisch: Weisen Sie das LLM beispielsweise an, nur ‘korrekt’ oder ‘falsch’ auszugeben oder auf einer Skala von 1-5 zu beurteilen. Rein qualitative Bewertungen sind schwer schnell und im großen Maßstab zu bewerten.

- Begründung fördern: Bitten Sie das LLM, zuerst zu denken, bevor es eine Bewertungspunktzahl entscheidet, und verwerfen Sie dann die Begründung. Dies erhöht die Bewertungsleistung, insbesondere für Aufgaben, die komplexe Beurteilungen erfordern.

Beispiel: LLM-basierte Bewertung

Beispiel: LLM-basierte Bewertung