Probar y evaluar

Usando la Herramienta de Evaluación

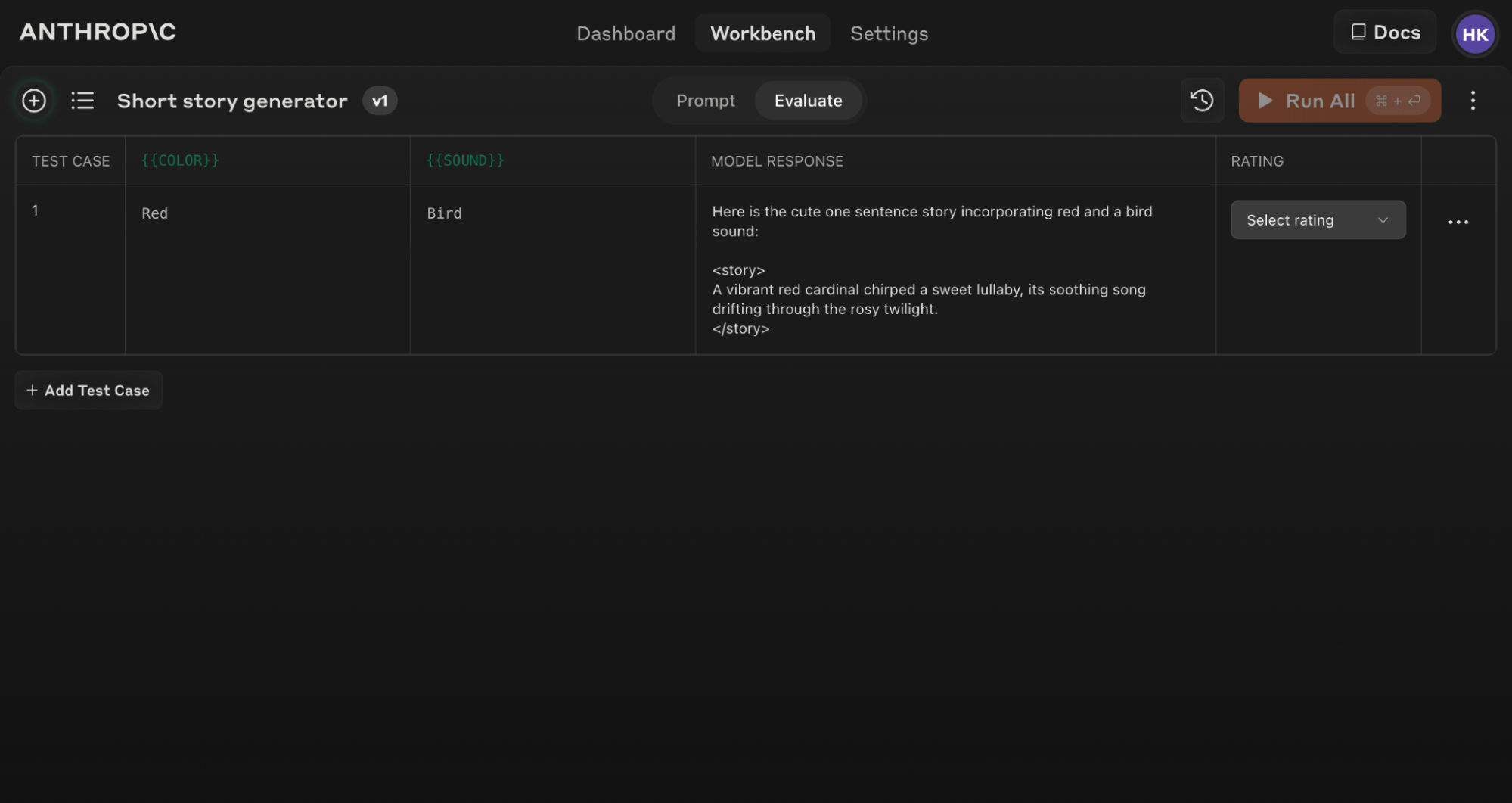

La Consola de Anthropic cuenta con una herramienta de Evaluación que te permite probar tus prompts bajo varios escenarios.

Accediendo a la Función de Evaluación

Para comenzar con la herramienta de Evaluación:- Abre la Consola de Anthropic y navega al editor de prompts.

- Después de componer tu prompt, busca la pestaña ‘Evaluate’ en la parte superior de la pantalla.

Asegúrate de que tu prompt incluya al menos 1-2 variables dinámicas usando la sintaxis de llaves dobles: {{variable}}. Esto es requerido para crear conjuntos de prueba de evaluación.

Generando Prompts

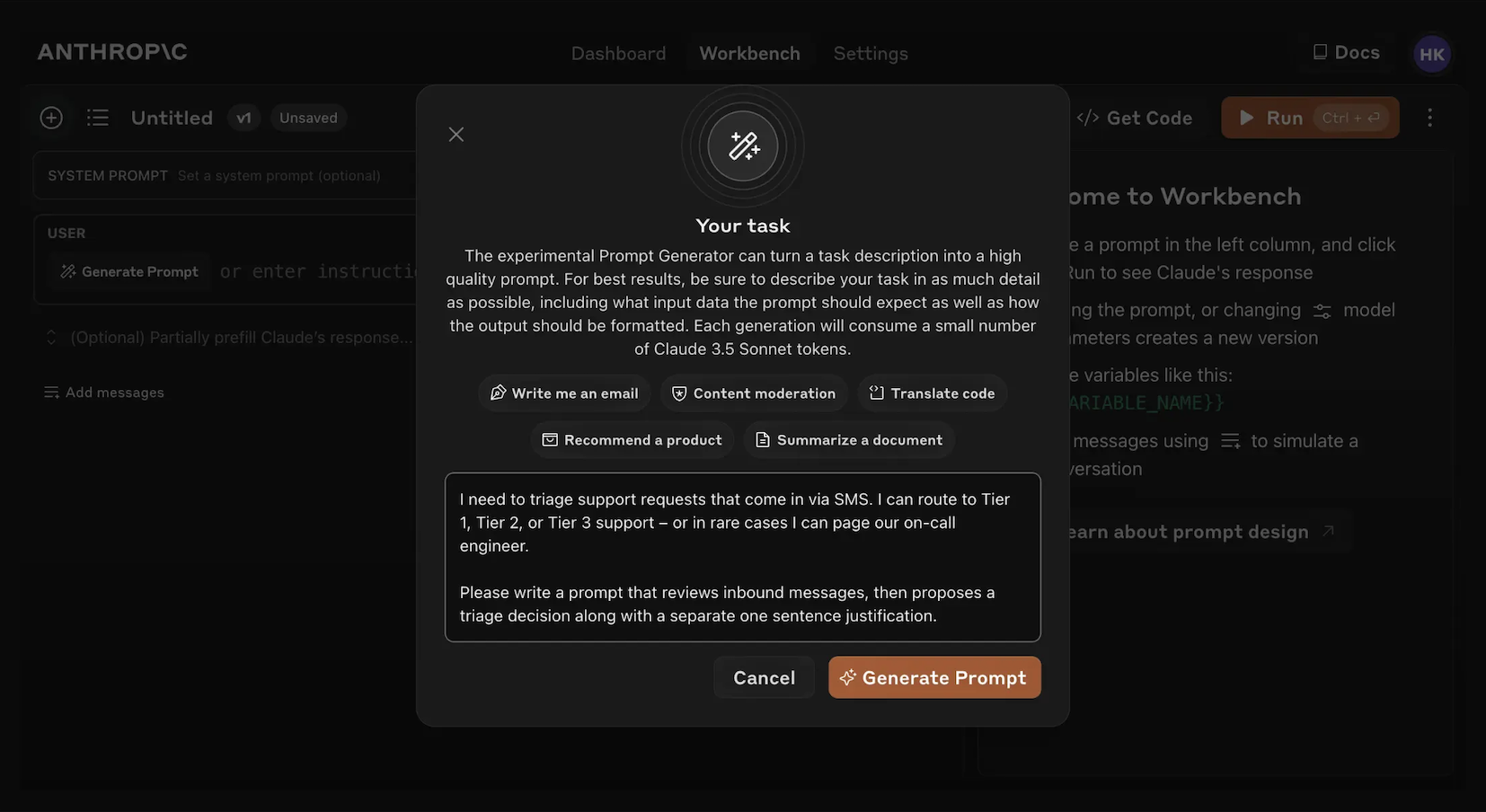

La Consola ofrece un generador de prompts integrado impulsado por Claude Opus 4.1:1

Haz clic en 'Generate Prompt'

Hacer clic en la herramienta auxiliar ‘Generate Prompt’ abrirá un modal que te permite ingresar la información de tu tarea.

2

Describe tu tarea

Describe tu tarea deseada (por ejemplo, “Clasificar solicitudes de soporte al cliente entrantes”) con tanto o tan poco detalle como desees. Mientras más contexto incluyas, más puede Claude adaptar su prompt generado a tus necesidades específicas.

3

Genera tu prompt

Hacer clic en el botón naranja ‘Generate Prompt’ en la parte inferior hará que Claude genere un prompt de alta calidad para ti. Luego puedes mejorar aún más esos prompts usando la pantalla de Evaluación en la Consola.

Creando Casos de Prueba

Cuando accedes a la pantalla de Evaluación, tienes varias opciones para crear casos de prueba:- Haz clic en el botón ’+ Add Row’ en la parte inferior izquierda para agregar manualmente un caso.

- Usa la función ‘Generate Test Case’ para que Claude genere automáticamente casos de prueba para ti.

- Importa casos de prueba desde un archivo CSV.

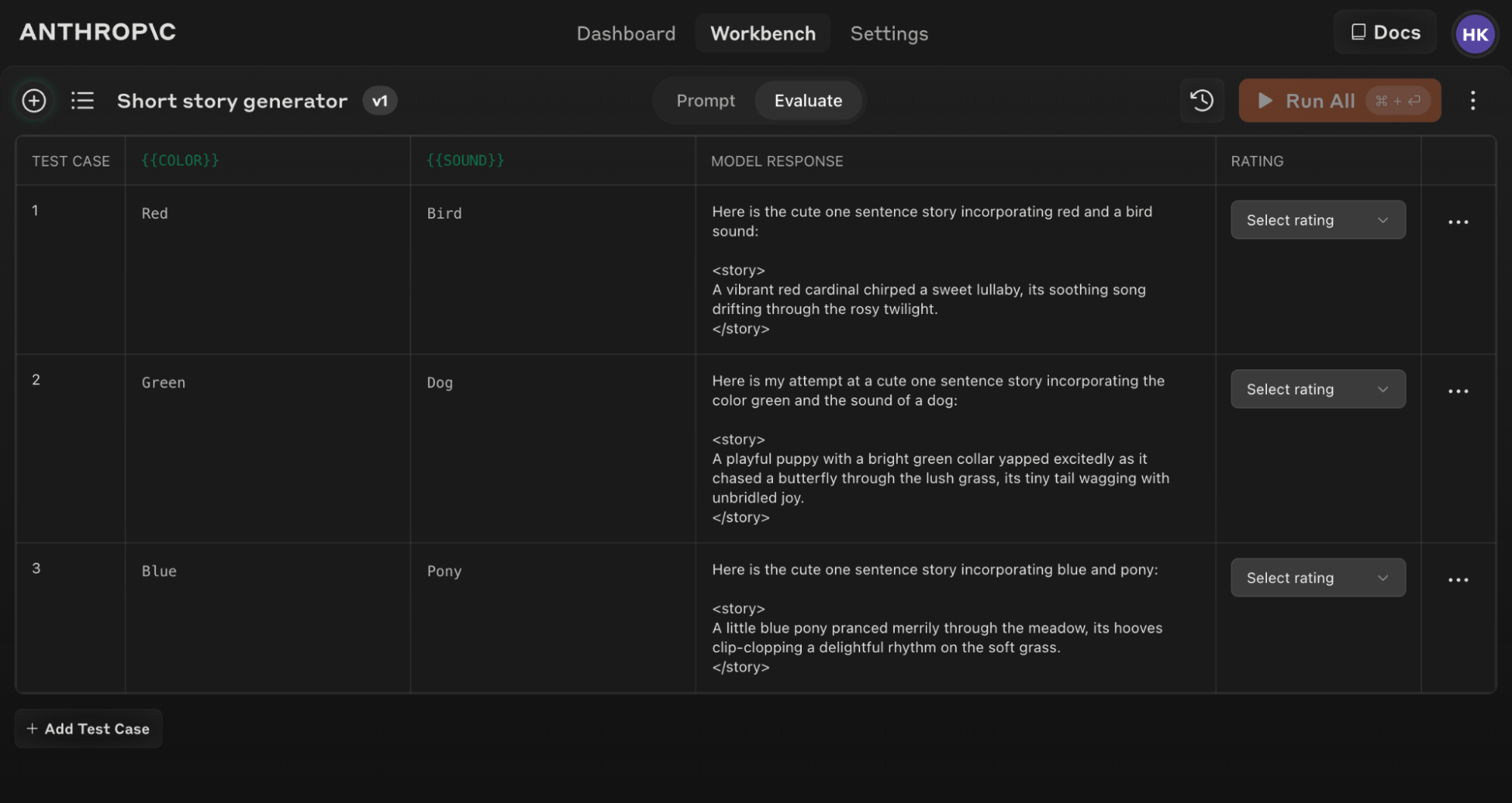

1

Haz clic en 'Generate Test Case'

Claude generará casos de prueba para ti, una fila a la vez por cada vez que hagas clic en el botón.

2

Edita la lógica de generación (opcional)

También puedes editar la lógica de generación de casos de prueba haciendo clic en el menú desplegable de flecha a la derecha del botón ‘Generate Test Case’, luego en ‘Show generation logic’ en la parte superior de la ventana de Variables que aparece. Es posible que tengas que hacer clic en `Generate’ en la parte superior derecha de esta ventana para poblar la lógica de generación inicial.Editar esto te permite personalizar y ajustar finamente los casos de prueba que Claude genera con mayor precisión y especificidad.

Si actualizas tu texto de prompt original, puedes volver a ejecutar toda la suite de evaluación contra el nuevo prompt para ver cómo los cambios afectan el rendimiento en todos los casos de prueba.

Consejos para una Evaluación Efectiva

Estructura de Prompt para Evaluación

Estructura de Prompt para Evaluación

Para aprovechar al máximo la herramienta de Evaluación, estructura tus prompts con formatos claros de entrada y salida. Por ejemplo:Esta estructura hace fácil variar las entradas ({{COLOR}} y {{SOUND}}) y evaluar las salidas consistentemente.

Usa la herramienta auxiliar ‘Generate a prompt’ en la Consola para crear rápidamente prompts con la sintaxis de variables apropiada para la evaluación.

Entendiendo y comparando resultados

La herramienta de Evaluación ofrece varias funciones para ayudarte a refinar tus prompts:- Comparación lado a lado: Compara las salidas de dos o más prompts para ver rápidamente el impacto de tus cambios.

- Calificación de calidad: Califica la calidad de respuesta en una escala de 5 puntos para rastrear mejoras en la calidad de respuesta por prompt.

- Versionado de prompts: Crea nuevas versiones de tu prompt y vuelve a ejecutar la suite de pruebas para iterar rápidamente y mejorar los resultados.