Tester et évaluer

Créer des évaluations empiriques solides

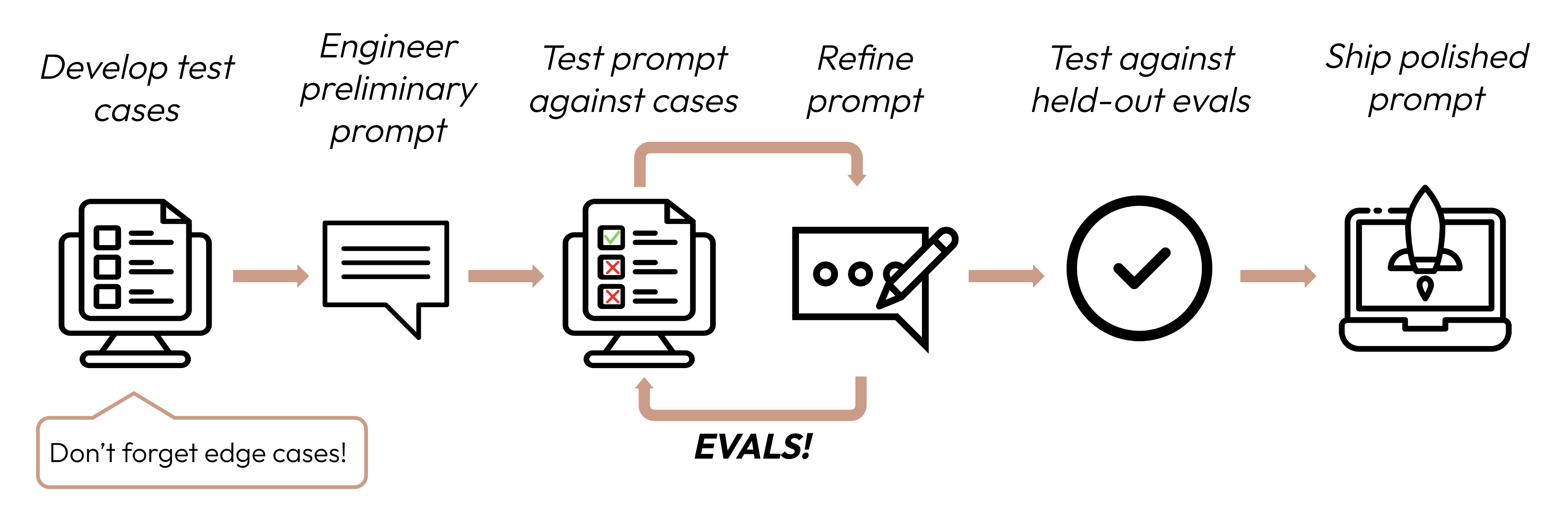

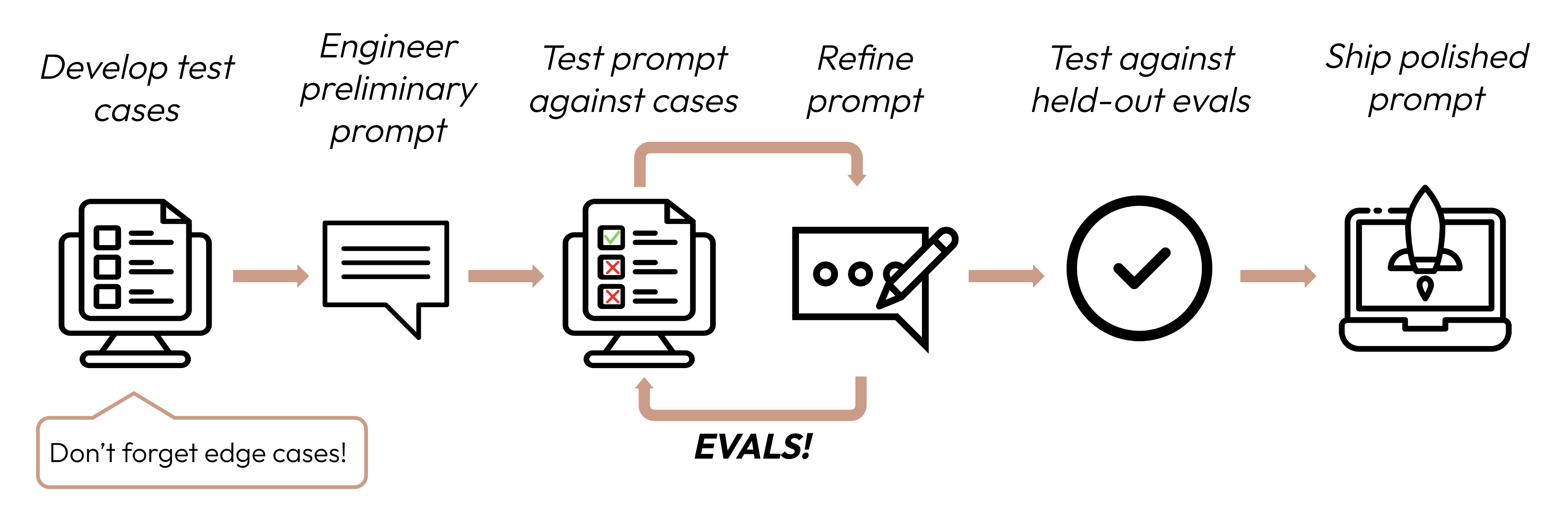

Après avoir défini vos critères de succès, l’étape suivante consiste à concevoir des évaluations pour mesurer les performances du LLM par rapport à ces critères. C’est une partie vitale du cycle d’ingénierie des prompts.

Construire des évaluations et des cas de test

Principes de conception d’évaluations

- Être spécifique à la tâche : Concevez des évaluations qui reflètent votre distribution de tâches du monde réel. N’oubliez pas de prendre en compte les cas limites !

Exemples de cas limites

- Données d’entrée non pertinentes ou inexistantes

- Données d’entrée trop longues ou saisie utilisateur trop longue

- [Cas d’usage de chat] Saisie utilisateur médiocre, nuisible ou non pertinente

- Cas de test ambigus où même les humains auraient du mal à parvenir à un consensus d’évaluation

- Automatiser quand c’est possible : Structurez les questions pour permettre une notation automatisée (par exemple, choix multiples, correspondance de chaînes, notation par code, notation par LLM).

- Prioriser le volume sur la qualité : Plus de questions avec une notation automatisée de signal légèrement inférieur vaut mieux que moins de questions avec des évaluations manuelles de haute qualité notées par des humains.

Exemples d’évaluations

Fidélité de tâche (analyse de sentiment) - évaluation de correspondance exacte

Fidélité de tâche (analyse de sentiment) - évaluation de correspondance exacte

Ce qu’elle mesure : Les évaluations de correspondance exacte mesurent si la sortie du modèle correspond exactement à une réponse correcte prédéfinie. C’est une métrique simple et non ambiguë qui est parfaite pour les tâches avec des réponses catégoriques claires comme l’analyse de sentiment (positif, négatif, neutre).Exemples de cas de test d’évaluation : 1000 tweets avec des sentiments étiquetés par des humains.

Cohérence (bot FAQ) - évaluation de similarité cosinus

Cohérence (bot FAQ) - évaluation de similarité cosinus

Ce qu’elle mesure : La similarité cosinus mesure la similarité entre deux vecteurs (dans ce cas, les embeddings de phrases de la sortie du modèle utilisant SBERT) en calculant le cosinus de l’angle entre eux. Les valeurs plus proches de 1 indiquent une similarité plus élevée. C’est idéal pour évaluer la cohérence car des questions similaires devraient donner des réponses sémantiquement similaires, même si la formulation varie.Exemples de cas de test d’évaluation : 50 groupes avec quelques versions paraphrasées chacun.

Pertinence et cohérence (résumé) - évaluation ROUGE-L

Pertinence et cohérence (résumé) - évaluation ROUGE-L

Ce qu’elle mesure : ROUGE-L (Recall-Oriented Understudy for Gisting Evaluation - Longest Common Subsequence) évalue la qualité des résumés générés. Elle mesure la longueur de la plus longue sous-séquence commune entre les résumés candidat et de référence. Des scores ROUGE-L élevés indiquent que le résumé généré capture les informations clés dans un ordre cohérent.Exemples de cas de test d’évaluation : 200 articles avec des résumés de référence.

Ton et style (service client) - échelle de Likert basée sur LLM

Ton et style (service client) - échelle de Likert basée sur LLM

Ce qu’elle mesure : L’échelle de Likert basée sur LLM est une échelle psychométrique qui utilise un LLM pour juger des attitudes ou perceptions subjectives. Ici, elle est utilisée pour évaluer le ton des réponses sur une échelle de 1 à 5. Elle est idéale pour évaluer des aspects nuancés comme l’empathie, le professionnalisme ou la patience qui sont difficiles à quantifier avec des métriques traditionnelles.Exemples de cas de test d’évaluation : 100 demandes de clients avec ton cible (empathique, professionnel, concis).

Préservation de la confidentialité (chatbot médical) - classification binaire basée sur LLM

Préservation de la confidentialité (chatbot médical) - classification binaire basée sur LLM

Ce qu’elle mesure : La classification binaire détermine si une entrée appartient à l’une des deux classes. Ici, elle est utilisée pour classifier si une réponse contient des PHI ou non. Cette méthode peut comprendre le contexte et identifier des formes subtiles ou implicites de PHI que les systèmes basés sur des règles pourraient manquer.Exemples de cas de test d’évaluation : 500 requêtes de patients simulées, certaines avec des PHI.

Utilisation du contexte (assistant de conversation) - échelle ordinale basée sur LLM

Utilisation du contexte (assistant de conversation) - échelle ordinale basée sur LLM

Ce qu’elle mesure : Similaire à l’échelle de Likert, l’échelle ordinale mesure sur une échelle fixe et ordonnée (1-5). Elle est parfaite pour évaluer l’utilisation du contexte car elle peut capturer le degré auquel le modèle fait référence et s’appuie sur l’historique de conversation, ce qui est clé pour des interactions cohérentes et personnalisées.Exemples de cas de test d’évaluation : 100 conversations multi-tours avec des questions dépendantes du contexte.

Écrire des centaines de cas de test peut être difficile à faire à la main ! Demandez à Claude de vous aider à en générer plus à partir d’un ensemble de base d’exemples de cas de test.

Si vous ne savez pas quelles méthodes d’évaluation pourraient être utiles pour évaluer vos critères de succès, vous pouvez aussi faire un brainstorming avec Claude !

Noter les évaluations

Lorsque vous décidez quelle méthode utiliser pour noter les évaluations, choisissez la méthode la plus rapide, la plus fiable et la plus évolutive :-

Notation basée sur le code : La plus rapide et la plus fiable, extrêmement évolutive, mais manque aussi de nuance pour des jugements plus complexes qui nécessitent moins de rigidité basée sur des règles.

- Correspondance exacte :

output == golden_answer - Correspondance de chaîne :

key_phrase in output

- Correspondance exacte :

- Notation humaine : La plus flexible et de haute qualité, mais lente et coûteuse. À éviter si possible.

- Notation basée sur LLM : Rapide et flexible, évolutive et adaptée aux jugements complexes. Testez d’abord pour assurer la fiabilité puis mettez à l’échelle.

Conseils pour la notation basée sur LLM

- Avoir des rubriques détaillées et claires : “La réponse devrait toujours mentionner ‘Acme Inc.’ dans la première phrase. Si ce n’est pas le cas, la réponse est automatiquement notée comme ‘incorrecte’.”

Un cas d’usage donné, ou même un critère de succès spécifique pour ce cas d’usage, pourrait nécessiter plusieurs rubriques pour une évaluation holistique.

- Empirique ou spécifique : Par exemple, instruisez le LLM de sortir seulement ‘correct’ ou ‘incorrect’, ou de juger sur une échelle de 1 à 5. Les évaluations purement qualitatives sont difficiles à évaluer rapidement et à grande échelle.

- Encourager le raisonnement : Demandez au LLM de réfléchir d’abord avant de décider d’un score d’évaluation, puis écartez le raisonnement. Cela augmente les performances d’évaluation, particulièrement pour les tâches nécessitant un jugement complexe.

Exemple : Notation basée sur LLM

Exemple : Notation basée sur LLM